Copyright © 2023 Dataiku. All rights reserved. | Online Privacy

Ebook

責任ある生成AIとは

優れたパワーには

大きな責任が伴います

生成AIへの関心の高まりに伴い、これまで以上に組織は AI システムを責任ある適切に管理された方法で構築するべく検討する必要があります。

このEBOOKでは、生成AIのリスクについて詳しく説明すると共に、責任ある AI のためのRAFT(Reliable:信頼性、Accountable:説明責任、Fair:公平性、Transparent:透明性)フレームワークを紹介し、従来型 AI システムと生成 AI システムの両方にどのように適 用できるか紹介します。

EBOOKをダウンロード

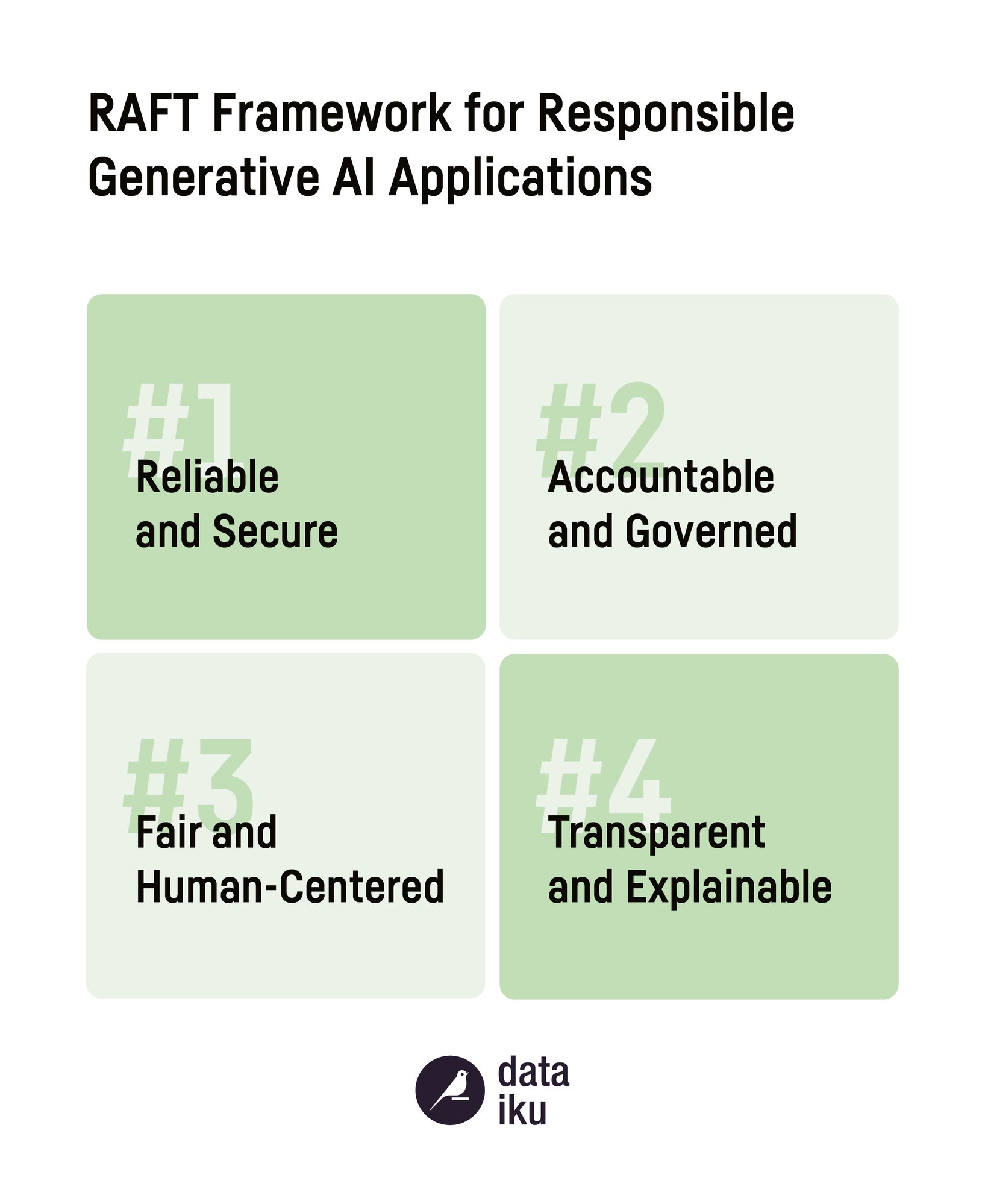

RAFT フレームワークの紹介

生成AIを含むすべての AI を責任あるものに

責任ある AI に対する Dataiku の基本的なアプローチを構成するもので、私たちはこれを Reliable( 信頼性)、Accountable( 説明責任)、Fair( 公平性)、 Transparent(透明性)を表す RAFT と呼んでいます。

これらの原則を効果的に実行するには、テクノロジーの潜在的なリスクと影響を理解する必 要があります。この EBOOK では、生成 AI 固有のリスクと、責任ある AI を実践 するための幅広いアプローチについて説明します。RAFT フレームワークの完全版も掲載されており、貴社に合わせ、利用いただけます。

生成 AI のリスク

企業における生成 AI の課題を緩和するには

有害、両極性、差別、人間とコンピューターの相互作用、偽情報、データプライバシー、モデルのセキュリティー、著作権侵害。これらのリスクは、さまざまなタイプの生成 AI テクノロジーに共通しますが、ユースケースによって表面化する方法は異なります。

上述のような潜在的な問題は言語モデルに限定されるものではありませんが、自然 言語処理(NLP)技術を使用してさまざまなビジネスコンテキストでテキストを分析、分類、 生成することにより、問題が発生しやすくなります。

LLM やその他の生成 AI 技術を AI システムに導入する前にこれらのリスクを把握して対処する ことは、最新のテクノロジーを責任を持って管理しながら使用するために不可欠です。

潜在的な影響を見極める

2つの軸で生成 AI の影響を理解します

- ソリューションの導入により、リスクが個人やグループに直接害を与える可能性がある かどうか、またはデプロイ時にそのリスクを特定することが難しい複数の要因の組み合 わせによって間接的に害を与える可能性があるかどうか。

- リスクがただちに、またはより長期にわたって弊害として表れる可能性があるかどうか。